上一个

CommandAI相关AI工具集

-

Grok-2Grok-2是xAI的前沿语言模型,具有最先进的推理能力。此次发布包括Grok家族的两个成员:Grok-2和Grok-2 mini。这两个模型现在都在...

Grok-2Grok-2是xAI的前沿语言模型,具有最先进的推理能力。此次发布包括Grok家族的两个成员:Grok-2和Grok-2 mini。这两个模型现在都在... -

Panto AIPanto AI 是一个编程辅助工具,通过代码审查来预防缺陷代码进入生产环境。它通过全天候运作,暴露代码中的漏洞并建议修复措施,确保只有无缺陷的代码被...

Panto AIPanto AI 是一个编程辅助工具,通过代码审查来预防缺陷代码进入生产环境。它通过全天候运作,暴露代码中的漏洞并建议修复措施,确保只有无缺陷的代码被... -

RegexBotRegexBot是一个利用人工智能技术将自然语言转换为强大正则表达式的在线工具。它通过简化正则表达式的创建过程,帮助用户轻松掌握正则表达式的使用,提高...

RegexBotRegexBot是一个利用人工智能技术将自然语言转换为强大正则表达式的在线工具。它通过简化正则表达式的创建过程,帮助用户轻松掌握正则表达式的使用,提高... -

GenieGenie是一款AI软件工程模型,它在SWE-Bench行业标准基准测试中取得了30%的评估分数,远超其他同类产品。Genie能够独立或与用户协作解决...

GenieGenie是一款AI软件工程模型,它在SWE-Bench行业标准基准测试中取得了30%的评估分数,远超其他同类产品。Genie能够独立或与用户协作解决... -

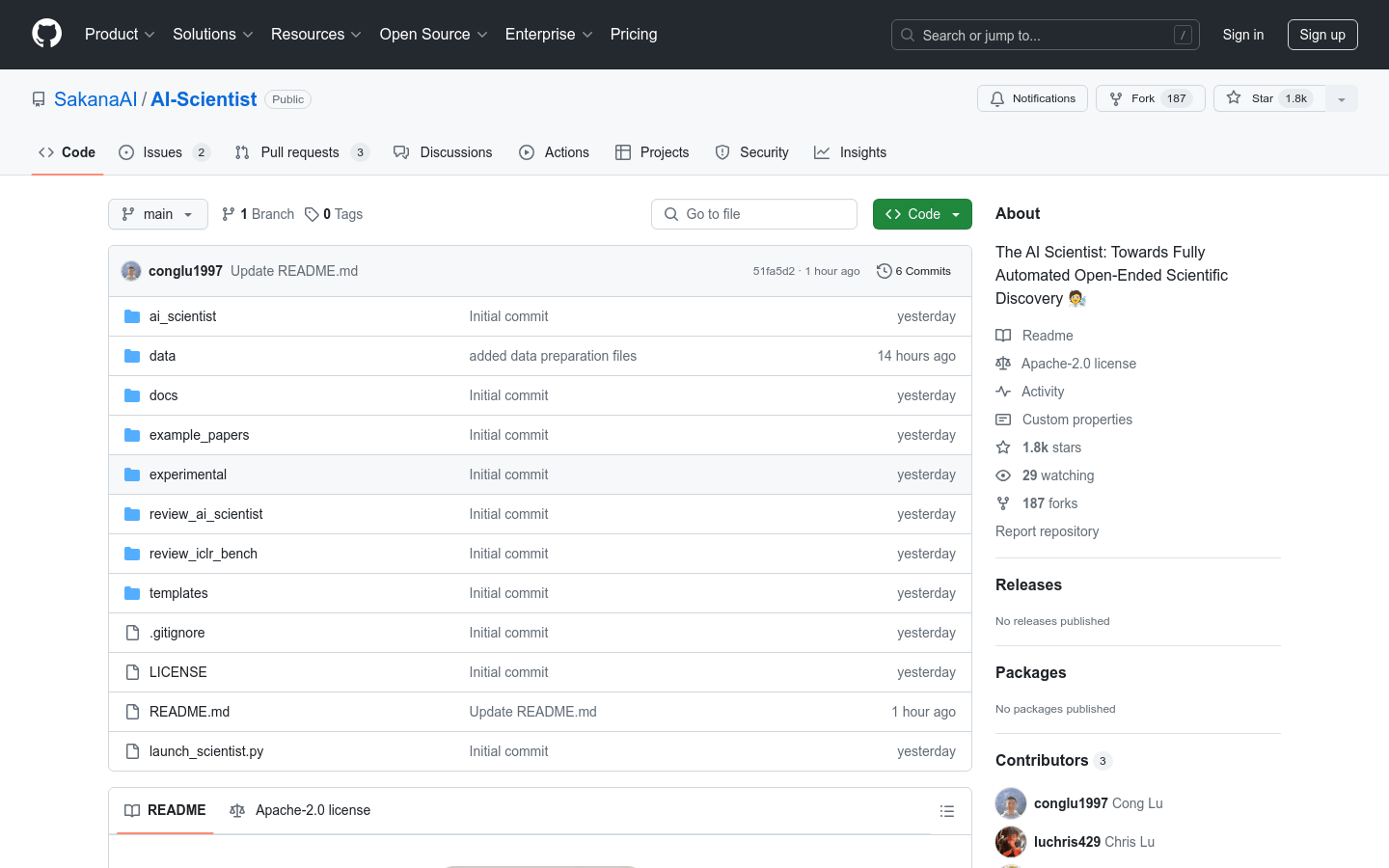

The AI ScientistThe AI Scientist 是一个全面的系统,旨在实现完全自动化的开放式科学发现。它使得基础模型,如大型语言模型(LLMs),能够独立进行研究。...

The AI ScientistThe AI Scientist 是一个全面的系统,旨在实现完全自动化的开放式科学发现。它使得基础模型,如大型语言模型(LLMs),能够独立进行研究。... -

TuskTusk是一个AI编码助手,专注于帮助软件工程师快速完成繁琐的代码任务。它通过自动化的方式生成代码,解决bug,进行UI/UX改进,从而提高开发效率,...

TuskTusk是一个AI编码助手,专注于帮助软件工程师快速完成繁琐的代码任务。它通过自动化的方式生成代码,解决bug,进行UI/UX改进,从而提高开发效率,... -

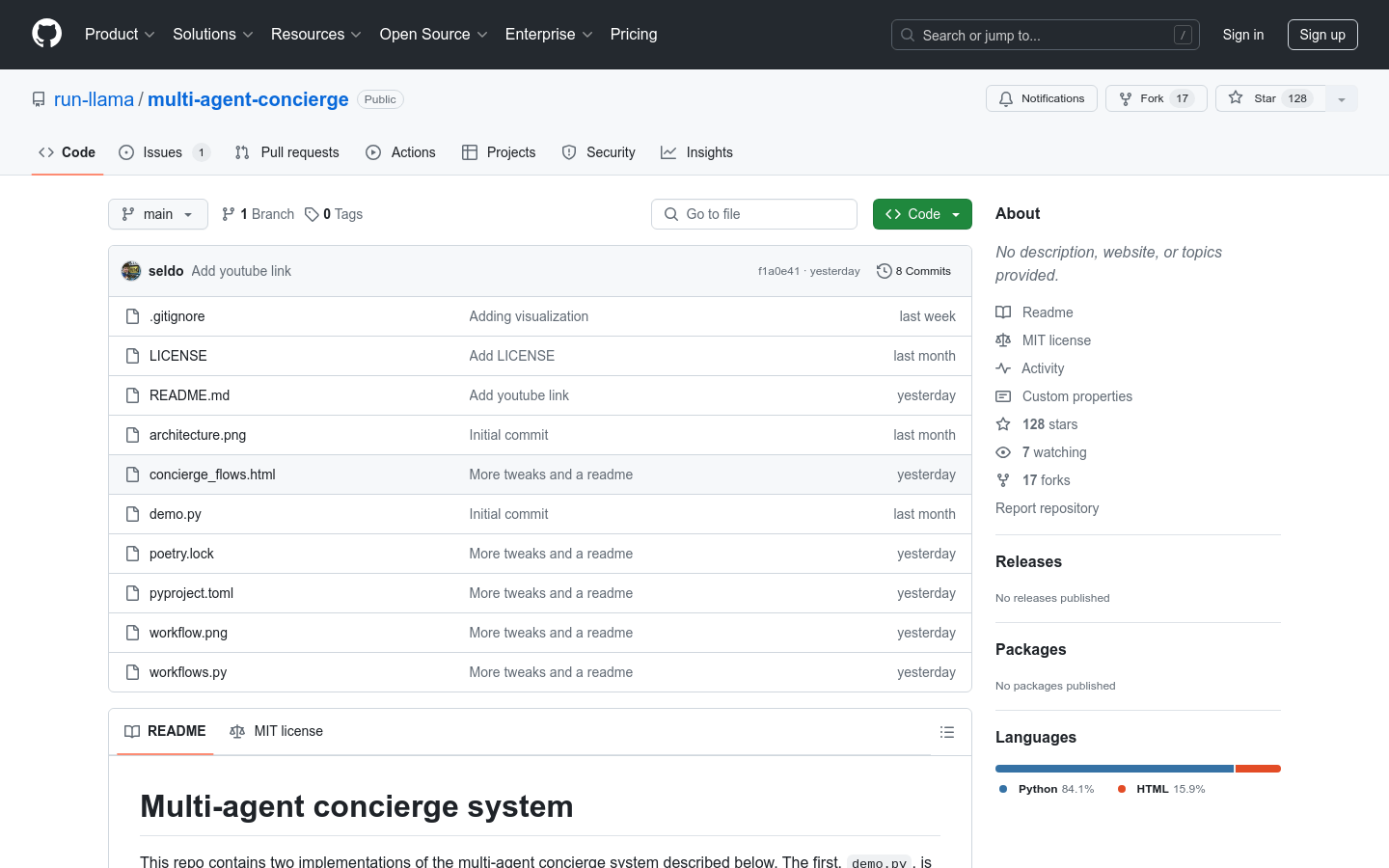

multi-agent-conciergemulti-agent-concierge是一个多代理礼宾系统,它通过多个专门的代理来完成复杂的任务,并通过一个“礼宾”代理来引导用户到正确的代理。这...

multi-agent-conciergemulti-agent-concierge是一个多代理礼宾系统,它通过多个专门的代理来完成复杂的任务,并通过一个“礼宾”代理来引导用户到正确的代理。这... -

SWE-bench VerifiedSWE-bench Verified是OpenAI发布的一个经过人工验证的SWE-bench子集,旨在更可靠地评估AI模型解决现实世界软件问题的能力。...

SWE-bench VerifiedSWE-bench Verified是OpenAI发布的一个经过人工验证的SWE-bench子集,旨在更可靠地评估AI模型解决现实世界软件问题的能力。... -

Llama CoderLlama Coder是一款基于人工智能的代码生成器,由Llama 3.1和Together AI共同驱动。它能够理解用户的想法,并将其转化为实际的应...

Llama CoderLlama Coder是一款基于人工智能的代码生成器,由Llama 3.1和Together AI共同驱动。它能够理解用户的想法,并将其转化为实际的应... -

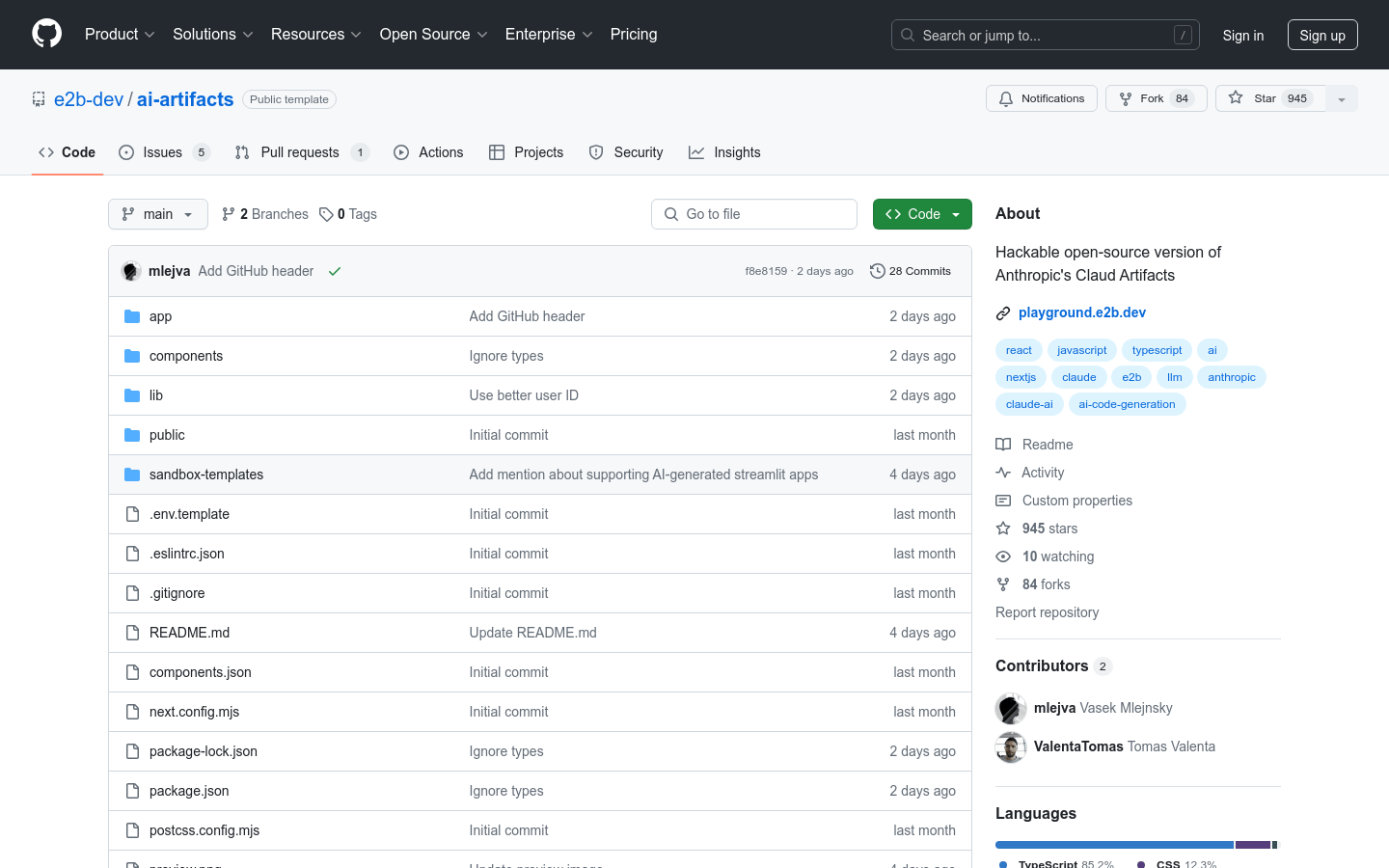

AI ArtifactsAI Artifacts是一个开源的Anthropic Claude Artifacts界面版本,使用E2B的代码解释器SDK和核心SDK执行AI代码...

AI ArtifactsAI Artifacts是一个开源的Anthropic Claude Artifacts界面版本,使用E2B的代码解释器SDK和核心SDK执行AI代码... -

ZeroPathZeroPath是一个自动化安全工具,旨在帮助开发者通过集成现有的静态应用程序安全测试(SAST)工具,自动验证和修复代码中的安全漏洞。它通过减少约9...

ZeroPathZeroPath是一个自动化安全工具,旨在帮助开发者通过集成现有的静态应用程序安全测试(SAST)工具,自动验证和修复代码中的安全漏洞。它通过减少约9... -

Frontend AIFrontend AI是一个开源的前端AI社区工具,它通过AI技术帮助开发者快速生成前端组件代码。用户可以通过简单的请求或上传图片,立即获得无需手动编...

Frontend AIFrontend AI是一个开源的前端AI社区工具,它通过AI技术帮助开发者快速生成前端组件代码。用户可以通过简单的请求或上传图片,立即获得无需手动编...

卓商AI

AI爱好者的一站式人工智能AI工具箱,累计收录全球10,000⁺好用的AI工具软件和网站,方便您更便捷的探索前沿的AI技术。本站持续更新好的AI应用,力争做全球排名前三的AI网址导航网站,欢迎您成为我们的一员。

最新收录

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

猜你喜欢

Spoke

Spoke是一款AI插件,为产品经理提供强大的、注重隐私的AI功能,能够在几秒钟内为用户提供上下文信息。它可以帮助全球快速增长的团队节省时间,创造上下...

LastMile AI

LastMile AI是一个AI开发平台,专为工程师而设计,可以用于原型开发和生成式AI应用的生产。它提供了一站式的多模态AI模型访问,包括语言模型(...

Dokkio

Dokkio是一款利用人工智能技术提供云文件协作的工具。它能帮助用户管理多个活动、搜索文档和文件、整理研究材料、组织内容库,并将所有文件和内容集中在一...

Engage Sphere AI

Engage Sphere是一个基于AI的员工参与度分析平台。它可以深入分析公司各个部门、团队和岗位的参与度,帮助管理者明确团队互动症结所在,并采取行...

Pikzels

Pikzels连接顶级人才和有远见的客户。我们促进协作,释放创意卓越。加入我们,获取来自各个领域的优秀专业人才。体验协作的力量,释放你的创意潜能。Pi...

Zoho Cliq

Zoho Cliq是一款专为提高企业工作效率而设计的在线即时通讯和协作平台。它将团队成员、对话和工作流集中在一个地方,实现无缝连接。主要功能包括:组织...

最新文章

1

2

3

4

5

6

7

8

9

10